Hoy en día, las redes de banda ancha no tienen una forma de filtrar el tráfico según la latencia. Y eso genera una desventaja significativa para las aplicaciones urgentes, como los juegos en línea o el comercio diario, que están ganando popularidad. Afortunadamente, eso está a punto de cambiar. DOCSIS de baja latencia (LLD), propuesto por CableLabs, especifica una separación lógica entre el tráfico regular y el tráfico sensible a la latencia. Al crear dos colas de tráfico separadas, los MSO tienen la oportunidad no solo de mejorar la experiencia del usuario, sino de ofrecer un nuevo nivel de servicio para generar ingresos adicionales.

La importancia de la baja latencia

En lo que respecta al rendimiento de la red, la velocidad y la latencia son métricas muy diferentes. Si bien están relacionados, y a menudo combinados, tienen requisitos únicos. Las altas velocidades permiten la transferencia de grandes cantidades de datos. Un buen ejemplo es la transmisión de video 4K desde YouTube o la descarga de un parche de software de 25 GB para un juego. Para que esto suceda rápidamente, son imprescindibles velocidades de ancho de banda altas. Sin embargo, hay ocasiones en las que la velocidad por sí sola no es suficiente para ofrecer una experiencia de la mejor calidad. Un claro ejemplo de ello es el popular juego online Call of Duty. La representación en tiempo real del entorno de juego dinámico es extremadamente exigente, con paquetes de datos típicos transmitidos a una tasa de bits de 100kbps a 200kbps tanto en el flujo ascendente como en el descendente. Pero esa es solo la mitad de la historia.

Debido a que Call of Duty está en línea, es interactivo e involucra a varios jugadores que compiten y colaboran en un servidor común, la latencia tiene un impacto posiblemente mayor en el juego que la velocidad. En este entorno de ritmo rápido, los retrasos de conexión de milisegundos son la diferencia entre el éxito y el fracaso. Como tal, la baja latencia es una ventaja bien reconocida en los videojuegos de multijugador en línea. Con una latencia más baja, es decir, el tiempo que los paquetes pasan llegando al servidor de juegos de Call of Duty y devolviendo una respuesta al jugador multijugador, los jugadores pueden literalmente ver y hacer cosas en el juego antes que otros. Más importante aún, es una ventaja por la que muchos jugadores están dispuestos a pagar. Si aplicamos esta misma lógica y ventaja competitiva a las finanzas, es obvio por qué tanto los profesionales como los aficionados también estarían dispuestos a pagar por ello.

¿Qué causa la latencia?

Para minimizar la latencia, es útil comprender sus condiciones subyacentes. En primer lugar, existen múltiples fuentes de latencia en las redes DOCSIS, incluidas las demoras en la cola de espera dependientes del protocolo y de la aplicación, demora de propagación, demora de solicitud y concesión, configuración de canal, así como demoras de conmutación y reenvío.

Normalmente, todo el tráfico de la red se fusiona en un único flujo de servicio DOCSIS. Este tráfico incluye tanto las transmisiones que crean colas, como las aplicaciones de transmisión de video, como las transmisiones que no crean colas, como las aplicaciones de juegos multijugador. El desafío que presenta esta arquitectura de flujo único es la falta de distinción entre los dos tipos de tráfico. Tanto la aplicación de juegos como la aplicación de transmisión de video se tratan de la misma manera en la red, pero sus necesidades son muy diferentes: un atasco de tráfico puede no ser importante para ver un video de YouTube, que puede almacenarse en búfer y reproducirse de forma asincrónica, sino para competir en un juego multijugador de Call of Duty, quedarse atrapado en la cola de transmisión de video es una sentencia de muerte. El tratamiento indiscriminado del tráfico en las redes DOCSIS actuales agrega latencia y fluctuación precisamente donde no es deseado.

La ventaja de DOCSIS de baja latencia

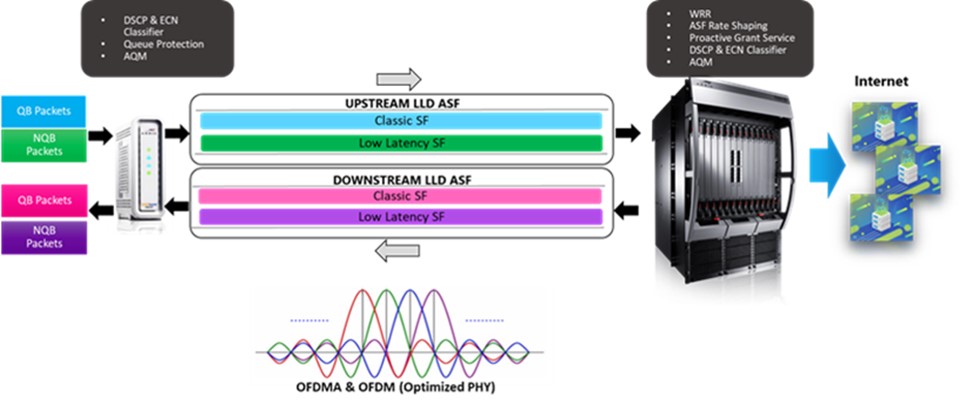

La arquitectura del LLD utiliza una construcción denominada Flujo de Servicio Agregado (ASF) para asignar sus dos flujos de servicio subyacentes al tráfico de creación de colas (conocido como "flujo de servicio clásico") y al tráfico sin formación de colas (conocido como "flujo de servicio de baja latencia”). Esta disposición resuelve precisamente el problema de las colas identificado anteriormente y garantiza que los datos de la aplicación de creación de colas en la red de acceso DOCSIS no provoquen retrasos en los datos urgentes que no son de creación de colas. En otras palabras, los videos de los clientes no se interpondrán en sus juegos.

Específicamente, la arquitectura LLD ofrece varias características clave nuevas:

Encapsulación de flujo de servicio ASF: LLD ASF gestiona la configuración del tráfico de ambos flujos de servicio mediante la aplicación de una Tasa máxima sostenida agregada (AMSR), en la que AMSR es el total combinado de las tasas de bits de flujo de servicio clásico y de baja latencia.

Programador Round Robin ponderado: el mecanismo de concesión en LLD se rige por un programador de flujo inter servicios Round Robin ponderado que se ejecuta en el CMTS, que prioriza condicionalmente el flujo de baja latencia a varias configuraciones configurables.

Tipo de programación de servicio de concesión proactiva: LLD presenta un nuevo y revolucionario tipo de programación de datos conocido como Servicio de concesión proactiva, que permite un ciclo de concesión de solicitud más rápido al eliminar la necesidad de una solicitud de ancho de banda.

Clasificación del tráfico del flujo de servicio: esta clasificación de paquetes juega un papel crucial al colocar un paquete dado en el flujo de servicio clásico o de baja latencia.

Algoritmos de gestión de colas activas: el nuevo flujo de servicio clásico utiliza el algoritmo DOCSIS PIE existente y descarta paquetes a medida que se crean colas para mantener una latencia objetivo. Mientras tanto, el flujo de servicio de baja latencia implementa un nuevo algoritmo AQM conocido como “Immediate AQM”, que no descarta paquetes, pero marca el campo ECN en el encabezado IP con bits de “Congestion Experienced” (CE) para asegurar una cola poco profunda. Los dos algoritmos AQM tienen probabilidades acopladas para garantizar que la capacidad de ancho de banda sea compartida por ambos flujos de servicio en el flujo de servicio agregado.

Protección queue: esta función clasifica los paquetes en los flujos de datos de la aplicación denominados microflujos y garantiza que cada microflujo se dirija al flujo de servicio adecuado según el tipo de tráfico de red (QB o NQB) y el umbral de latencia crítico.

Histogramas de latencia: una nueva función de histograma ofrecerá una mayor visibilidad de los búferes de flujo de servicio y las acumulaciones de cola.

En resumen, LLD tiene la capacidad de agregar algunas características nuevas y emocionantes a las redes DOCSIS tradicionales. Para comprender exactamente cómo funcionan y captar un vistazo de las ganancias de rendimiento, configuramos varios experimentos utilizando LLD en una red DOCSIS 3.1. Los resultados de estas pruebas se pueden encontrar en nuestro documento técnico.

También lo invitamos a comunicarse con nosotros para obtener más información sobre LLD y cómo puede funcionar en su red. CommScope tiene una variedad de recursos disponibles para ayudarlo a capturar los beneficios de esta especificación para mejorar la experiencia del usuario y crear nuevas oportunidades de ingresos.

Nota para los lectores: el artículo original se publicó por primera vez en febrero de 2021 en la publicación Fast Mode.